| 2022-07-03

这是关于Netflix如何利用 A/B 测试来做决策,以及不断创新产品的系列文章中的第二篇。 接下来的文章内容主要是深入 Netflix 所用 A/B 试验的统计方式,以及 Netflix 为了支持大规模的试验而在基础设施上的投入,以及实验文化在 Netflix 的重要性。这里 是第一篇的内容:Netflix 如何做决定。

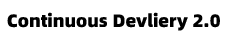

A/B 测试 就是一种简单的对照实验。比如,我们想了解一种新的产品体验,下面就是一个假说:将电视用户界面中的所有 boxart 倒置过来,是否对我们的会员有益。

图1:我们如何决定产品体验 B(倒置的 Box Art )是否对会员来说是更好的体验?

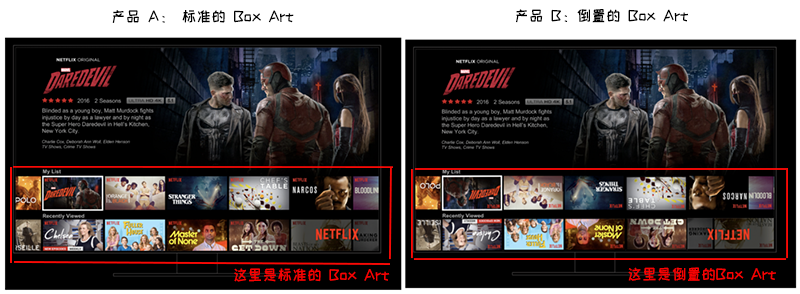

为了进行实验,我们从我们的会员中选取一个子集, 通常是一个简单随机样本,然后使用随机分组的方式 将样本平均分为两组。A 组 常被称为 「对照组」,保持原有的 Netflix 基础用户界面体验,而 B 组被称为 「实验组」,会体验一个不同的界面,这个界面基于关于改善会员体验的特定假设(更多关于这些假设的信息,请参见下文)。在这里,B 组会员会看到 倒置的 BoxArt 。

我们会等待一段时间,之后会比较 A 组和 B 组的各种指标值。有些指标将特定于给定的假设。

对于 UI 实验,我们将研究与新功能的不同变体的互动。

若是对于一个旨在搜索体验中提供更相关结果的实验,我们则将衡量成员是否通过搜索找到了更多可观看的内容。

在其他类型的实验中,我们可能会关注更多的技术指标,例如应用程序加载所需的时间,或者我们在不同网络条件下能够提供的视频质量。

Figure 2: 一个简单的A/B测试。我们使用随机分配将 Netflix 成员的随机样本分成两组。A 组接受当前的产品体验,而 B 组接受一些我们认为是对 Netflix 体验的改进。在这里,B组获得了「倒置 Box Art」的产品体验。然后,我们比较两组之间的指标。关键是,随机分配确保了平均分配,而两组之间的其他一切保持不变。

通过许多实验,包括上面提到的「倒置 Box Art 」示例,我们需要仔细思考我们的指标到底告诉了我们什么样的事实。

假设我们使用点击率,用它衡量每次体验中点击标题的会员比例。

然而,这个指标本身可能是衡量这个新界面是否成功的一个误导性指标,因为会员可能只是为了更容易阅读而点击「倒置 Box Art」这个产品体验中的标题而已。在这种情况下,我们可能还要评估哪些会员随后离开了这个标题,而不是继续使用它。

对于所有场景,还应该研究更为通用的指标,用于捕捉 Netflix 为会员带来的喜悦和满足感。这些指标包括会员参与 Netflix 的程度:所要验证的这个方案是否有助于让 Netflix 会员在任何时候都会选择 Netflix 作为他们的娱乐途径?

当然,还会涉及很多统计数据在内。例如,差异到底有多大才会被认为是显著差异?为了检测给定幅度的影响程度,在这个试验中到底需要多少会员参与其中?如何最有效地分析数据?随后的文章中会介绍其中的一些细节,来重点关注高级别的直觉。

一定要保持其他方面一切不变

因为我们使用随机分配创建了对照组「 A 」和实验组「 B 」,所以,一般来说,我们可以确保这两个组中的个体在所有对试验有影响的维度上是均衡的。例如,随机分配以确保 Netflix 会员的会员资格时长,在对照组和实验组之间没有显著差异,还有内容偏好、主要语言选择等也没有显著差异。两组之间唯一剩下的区别是我们正在测试的新体验,确保我们对新体验影响的估计没有任何偏见。

为了理解这一点的重要性,让我们考虑另一种决策方式:我们可以向所有 Netflix 会员推出新的「倒置 Box Art」(如上所述),看看我们的某个指标是否有重大变化。如果有积极的变化,或者没有任何有意义的变化,我们就会保留这个新体验;如果有证据表明出现了负面变化,我们将回到之前的产品体验。

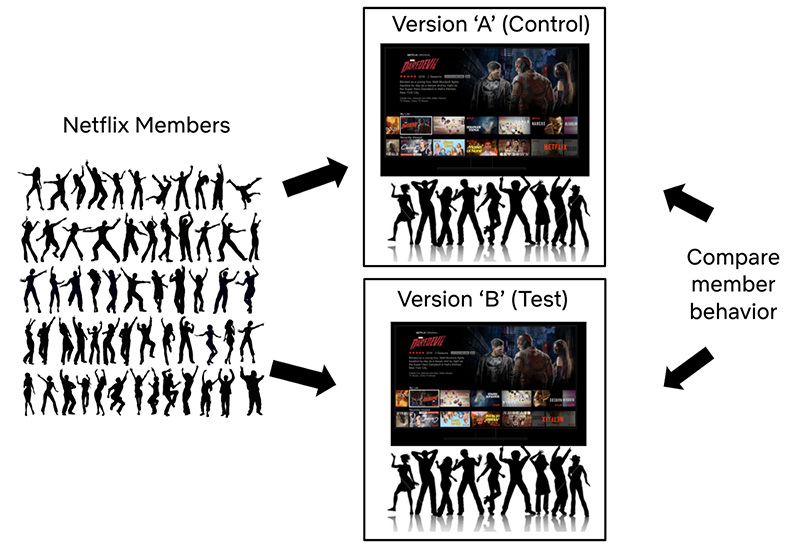

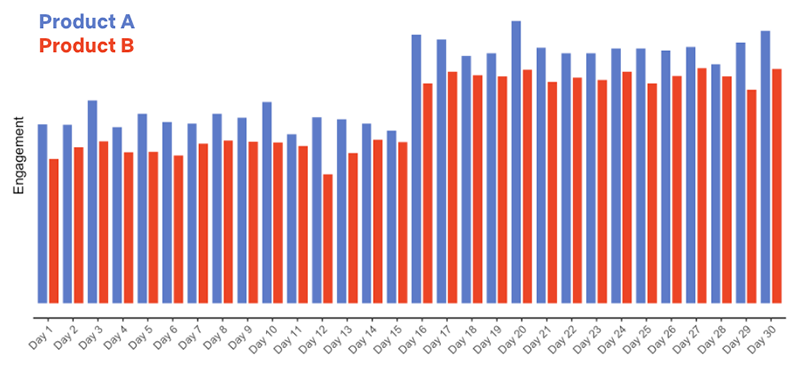

假设我们这么做了(即:回到原来的体验。当然,这就又建立了一个假设!),然后在一个月的第 16 天时将开关再次切换到「倒置 Box Art」的体验。假如我们收集到了以下数据,那么,你会怎么做?

图 3: 第16天发布新的「倒置 Box Art 」产品体验的数据.

图 3: 第16天发布新的「倒置 Box Art 」产品体验的数据.

数据看上去不错:我们发布了新的产品体验,会员参与度大大提高!但是,如果你有了这些数据,再加上产品 B 将用户界面中的所有「倒置 Box Art」的知识,你对新产品体验对会员产生的真正影响,到底有多大信心?

我们真的确信新的产品体验是导致会员参与度增加的主要因素吗?还有其他可能的解释吗?

如果你还知道,Netflix 发布了一个热门标题,比如新一季的「怪奇物语」或者「布里奇顿家族」,又或者热门电影,比如「活死人军团」,而同一天,这个新的产品体验「倒置 Box Art 」也发布了。那么,现在对「点击率的增长」就又有了一条可能的解释:它即可能是因为新产品体验,也可能是社交媒体上的热门话题,两者都有可能。又或者是一个其它完全不同的原因。关键是,我们并不知道新产品体验是否真的导致了会员参与度的增加。

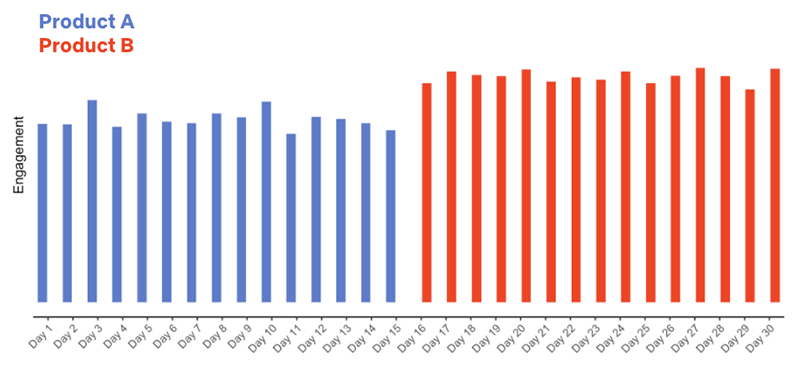

相反,如果我们用「倒置 Box Art 」产品体验进行A/B测试,其中一组成员 A 在整个月内收到原有体体的产品,而另一组 B 收到「倒置 Box Art 」产品,并收集了以下数据,分析结果会怎么样?

图 4: 新产品体验的 A/B 试验数据

图 4: 新产品体验的 A/B 试验数据

在这种情况下,我们会得出不同的结论:「倒置 Box Art 」产品通常会导致较低的参与度(这并不奇怪!),在推出热门标题的同时,这两个群体的参与度都增加了。

A/B 测试让我们做出因果关系的推断。我们只在 B 组中引入了「倒置 Box Art 」产品体验,同时,我们是随机将会员分配到 A 组和 B 组的,所以,这两组之间的其他一切因素都保持不变。因此,我们很可能得出结论(下次将详细介绍):「倒置 Box Art 」导致参与度降低。

当然,我们用的这个假说例子相对极端了一点,但值得学习经验的是,总有一些事情,我们是无法控制的。如果我们向每个人介绍一次体验,并简单地在更改前后测量某个指标,那么这两个时间段之间可能存在相关差异,从而阻止我们得出因果结论。也许是因为一个热门标题,也许是因为这个新的产品体验,为更多用户打开了 Netflix 的大门。总有一些事情是我们不知道的。在可能的情况下,通过使用 A/B 测试,我们可以证实因果关系,并自信地对产品进行更改,因为我们的成员已经通过他们的行为对其进行了投票。

这一切都是从一个想法开始

任何一个 A/B 测试都从一个想法开始的。我们可以对用户界面、帮助会员查找内容的个性化推荐系统、新会员的注册流程,或我们认为能为会员带来积极结果的 Netflix 体验的任何部分进行一些更改。我们所做的测试中,有一些是渐进式创新,例如改进 Netflix 产品中出现的文本副本的方法;而有些则可能是更为雄心勃勃的,比如 Netflix 在用户界面上显示的「 Top 10」列表。

正如所有向全球 Netflix 会员推出的创新一样,「Top 10 列表」最初也只是一个想法,后来变成了一个可验证的假设。

在这里,其核心思想是:在每个国家使用流行的「十大」系列,在有两个方面有利于我们的成员。首先,通过展示流行内容,我们可以帮助会员分享经验,并通过关于这些流行标题的对话产生相互联系。第二,我们可以通过满足人类参与共享这些对话的内在愿望,帮助会员选择一些精彩的内容观看。

图 5 :在 Web 界面上的「 Top 10 」的一个例子

图 5 :在 Web 界面上的「 Top 10 」的一个例子

接下来,我们将这个想法转化成一个可验证的假说。一般来说,一个假说的句式如下: “如果我们做出 X 这样的变化,它将以一种使指标 Y 改善的方式改善会员体验。”

在 Top 10 这个例子中,假说看上去应该这样写:

“向会员展示「Top 10 表表」的新体验,将会帮助他们找到值得观看的内容,增加会员的快乐和满意度。”

这项测试(以及许多其他测试)的主要决策指标是衡量会员对 Netflix 的参与度:我们正在测试的想法是否有助于会员在任何一个夜晚都会选择 Netflix 作为他们的娱乐方式?

我们的研究表明,从长远来看,这一指标(细节省略)与会员保留订阅的概率相关。我们运行测试的其他业务领域,例如「注册页面」的体验,或者是关于服务器端基础设施的,各自都使用了不同的主要决策指标,但是,原则是相同的,那就是:

在测试期间,我们可以衡量哪些指标,它会与「为会员提供更多长期价值」这一点保持一致?

除了验证这个主要决策指标外,我们还会考虑了一些次要指标,以及它们将如何受到我们正在测试的产品功能的影响。我们的目标是阐明因果链,从「用户行为如何响应新产品体验的变化」到「我们主要决策指标的变化」的因果链。

阐明产品变化与主要决策指标变化之间的因果链,并沿着该链监测次要指标,有助于我们建立信心,即:我们主要指标的任何变化都是我们假说的因果链的结果,而不是新特性带来的意外后果(或误报——在后面的帖子中会有更多内容!)。

对于「 Top 10 」这个测试,参与度是我们的主要决策指标,但我们也会查看其它指标,例如 Top 10 列表中所出现的标题的不同热度,以及对同一标题,自该列表的查看与UI上其他页面的查看比例等。如果「 Top 10 」的体验真的符合假设,对 Netflix 会员有好处,我们就希望实验组能够增加对「 Top 10 」列表中所现标题的浏览量,并从这里点击所获得普遍意义上的积极参与度。

最后,因为并不是我们验证的想法都能为我们赢得会员的参与(有时新功能也有bug!),我们还会研究并指定一些充当「护栏」的指标。我们的目标是限制任何负面影响,并确保新产品体验不会对会员体验产生意外影响。例如,我们可能会比较对照组和实验组的客服联系人,以检查新功能是否增加了客服接触率,接触率增加,可能表明新的试验让会员感到困惑或不满意。

小结

本文的重点是:帮助读者建立 对 A/B 的第一印象。例如:

- A/B测试的基础

- 为什么 运行A/B测试与推出一个特性和查看做出更改前后的指标很重要

- 如何将一个想法转化为可测试的假设。

下一篇,我们将讨论对实验组和对照组进行指标对比时,所使用的基本统计概念。

术语

简单随机抽样(Simple Random Sampling),也叫纯随机抽样。从总体 N个 单位中随机地抽取 n 个单位作为样本,使得每一个容量为样本都有相同的概率被抽中。特点是:每个样本单位被抽中的概率相等,样本的每个单位完全独立,彼此间无一定的关联性和排斥性。简单随机抽样是其它各种抽样形式的基础。通常只是在总体单位之间差异程度较小和数目较少时,才采用这种方法。

随机分配( Random Assignment ),或随机放置,是一种实验技术,用于将人类参与者或动物受试者分配到实验中的不同组(例如,实验组与对照组),使用随机化,例如通过随机程序(例如,掷硬币)或一个随机数发生器。这确保了每个参与者或受试者都有平等的机会被分配到任何组中。参与者的随机分配有助于确保组之间和组内的任何差异都不是系统性的在实验开始时。因此,在实验结束时记录的组之间的任何差异都可以更自信地归因于实验程序或治疗。

原文作者:Netflix TechBlog

原文链接:Rapid release at massive scale

发表时间: Sep 22, 2021